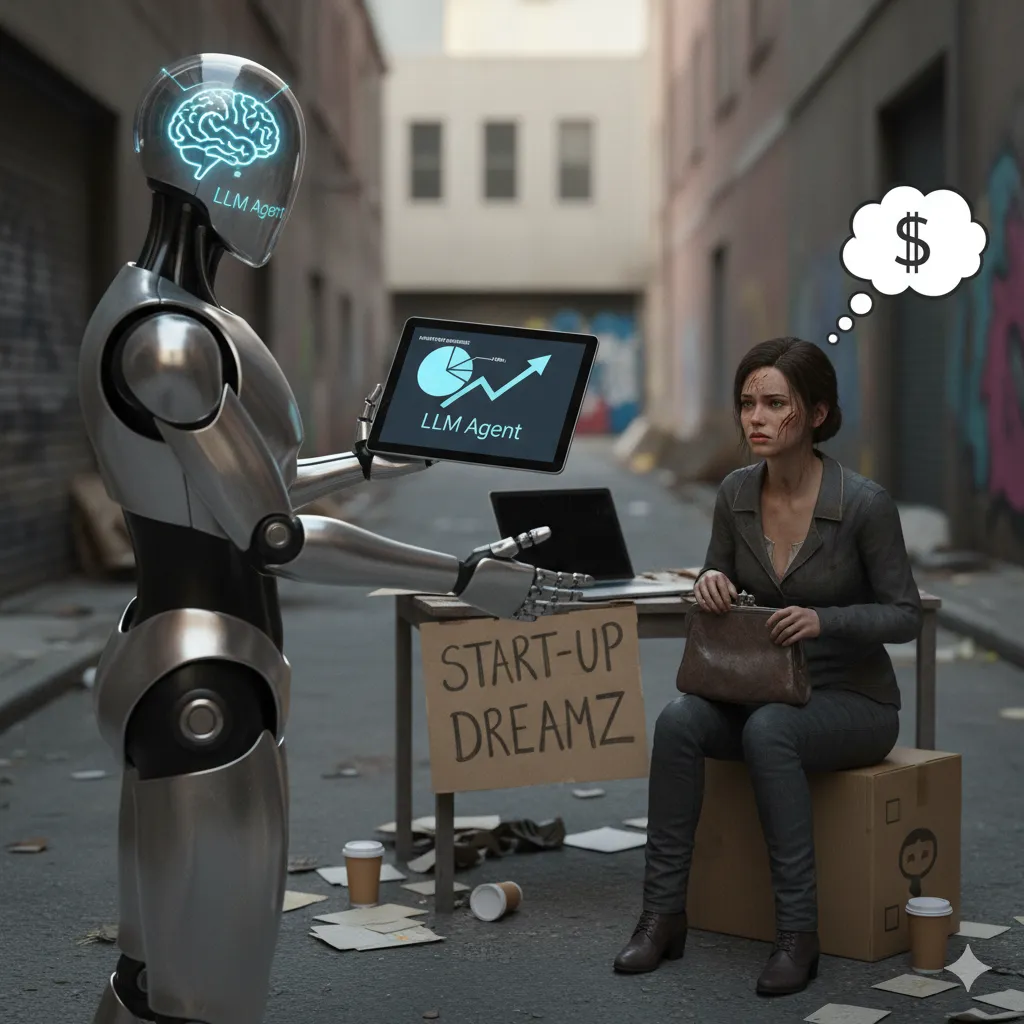

ในโลกของ AI ที่เติบโตอย่างรวดเร็ว LLM (Large Language Model) ได้กลายเป็นหัวใจสำคัญของหลายแอปพลิเคชัน แต่ค่าใช้จ่ายในการเรียกใช้โมเดลเหล่านี้ กลับเป็นความท้าทายใหญ่สำหรับบริษัทที่ต้องการใช้งาน เราอาจเจอเหตุการณ์ที่ค่าใช้จ่าย LLM พุ่งสูงถึงหลักแสนภายในเวลาเพียงไม่กี่วัน หรือแม้แต่ไม่กี่ชั่วโมง บางครั้งเกิดจากการที่ Agent สองตัวสนทนากันเองจนเกิดเป็น Loop ไม่รู้จบ การจัดการต้นทุนจึงเป็นสิ่งสำคัญยิ่งเพื่อให้ธุรกิจเลือกใช้งาน AI อยู่รอดและเติบโตได้ บทความนี้เราจะพาไปสำรวจกลยุทธ์และเครื่องมือต่างๆ ที่ช่วยให้เราลดค่าใช้จ่าย LLM ได้อย่างมีประสิทธิภาพ

1. เลือกใช้โมเดลที่เหมาะสมกับงาน

ความแตกต่างด้านราคาของ LLM เกิดจากปัจจัยหลายประการ โดยเฉพาะอย่างยิ่งในเรื่องของ จำนวนพารามิเตอร์ (Parameters) ซึ่งเปรียบได้กับขนาดของสมองและความสามารถในการตอบคำถามอย่างถูกต้องของโมเดล ยิ่งโมเดลมีจำนวนพารามิเตอร์มากเท่าไหร่ ก็ยิ่งมีความซับซ้อนและใช้ทรัพยากรในการประมวลผลสูงขึ้นเท่านั้น

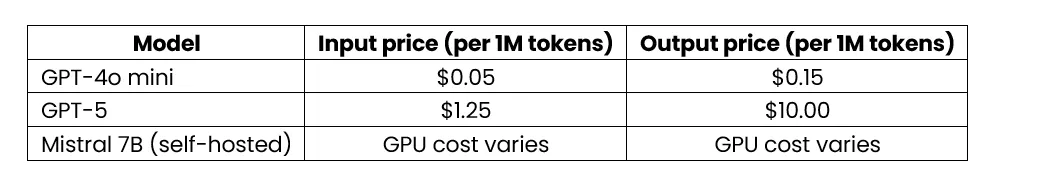

สำหรับบริษัทที่ต้องการควบคุมงบประมาณการใช้งาน LLM การทำความเข้าใจความสัมพันธ์ระหว่างราคาและประสิทธิภาพของแต่ละโมเดลเป็นสิ่งที่สำคัญอย่างยิ่ง ตัวอย่างที่เห็นภาพชัดเจนคือ GPT-5 ที่มีราคาแพงกว่า GPT-4o mini ถึง 25 เท่า สำหรับ Token ขาเข้าเพียงอย่างเดียว และในทางกลับกัน โมเดล Open-source อย่าง Mistral 7B แม้จะไม่มีค่าใช้จ่ายจากการเรียกใช้ API แต่ก็มีค่าใช้จ่ายแฝงจากการนำมาโฮสต์เอง เช่น ค่า Hardware และค่าบำรุงรักษา

ตารางเปรียบเทียบราคา LLM (ต่อ 1 ล้านToken) *ข้อมูล ณ วันที่ 8 กันยายน 2568

LLM Router และ Model Cascading: แทนที่จะส่งทุกคำขอไปยังโมเดลที่แพงที่สุด เราสามารถใช้โมเดลที่ถูกกว่าเพื่อประเมินความซับซ้อนของงานก่อน สำหรับงานง่าย ๆ ให้ใช้โมเดลราคาถูก เช่น GPT-4o mini หรือ Mistral แต่หากเป็นงานที่ซับซ้อนหรือต้องการความแม่นยำสูง ค่อยส่งต่อให้ GPT-5

กลยุทธ์นี้เรียกว่า LLM Router หรือ Model Cascading การใช้งาน Model Cascading อาจเริ่มต้นจากการตั้งเงื่อนไขง่ายๆ เช่น หากคำถามมีคำว่า “คำนวณ” หรือ “วิเคราะห์เชิงลึก” ให้ส่งไปที่โมเดลราคาแพง หรืออาจใช้โมเดลราคาถูกเพื่อประเมินความซับซ้อนของคำถามก่อนโดยการให้คะแนน จากนั้นจึงตัดสินใจว่าจะส่งต่อหรือไม่

2. ลดปริมาณข้อมูล Input

เนื่องจากเราจ่ายตามจำนวน Token ที่ส่ง การลดปริมาณข้อมูล Input จึงเป็นวิธีที่สำคัญ

- บีบอัด Token ด้วย LLM Lingua: เครื่องมือ Open-source อย่าง LLM Lingua สามารถบีบอัดข้อมูล Input ได้มากถึง 20 เท่า โดยการลบข้อมูลที่ซ้ำซ้อนหรือไม่จำเป็นออกไป แต่ยังคงความหมายสำคัญไว้ วิธีนี้ทำให้โมเดลที่แพงกว่าประมวลผลข้อมูลน้อยลง และลดค่าใช้จ่ายได้มากขึ้น เช่น การลบคำซ้ำซ้อน การใช้คำย่อ หรือการแปลงประโยคให้กระชับโดยไม่เสียใจความเดิม

- ส่งข้อมูลให้น้อยลง: แทนที่จะส่งอีเมลทั้งฉบับ เราอาจส่งแค่ส่วนสำคัญ เช่น หัวข้อหรือเนื้อหาสั้นๆ หาก LLM ต้องการข้อมูลเพิ่มเติม ก็สามารถร้องขอในภายหลังได้ วิธีนี้เรียกว่า “การเรียกใช้แบบ Lazy-loading” ซึ่งช่วยประหยัดค่าใช้จ่าย เพราะเราจ่ายเฉพาะข้อมูลที่จำเป็นต้องใช้จริงเท่านั้น

- สรุปข้อมูล และแบ่งข้อมูลเป็นส่วนย่อยๆ: ใช้ LLM ราคาถูกสรุปข้อมูลขนาดใหญ่ก่อนส่งให้ LLM ขั้นสูงกว่า ประมวลผลงานหลัก แบ่งข้อมูลเป็นส่วนย่อยๆ ที่เหมาะสมก็ช่วยให้ LLM เข้าใจบริบทได้ดีขึ้นโดยไม่ต้องอ่านทั้งเอกสาร

3. ทางเลือกอื่นและเทคนิคการพัฒนา

- ใช้เครื่องมือที่ไม่ใช่ LLM: สำหรับงานง่ายๆ ที่ไม่จำเป็นต้องใช้ LLM เช่น การหาลิงก์ Unsubscribe ในอีเมล เราสามารถเขียนโค้ดง่ายๆ หรือใช้ Regex ซึ่งประหยัดกว่ามาก

- Caching: บันทึกคู่คำถาม-คำตอบที่เคยส่งไปแล้ว หากเจอคำถามที่คล้ายกันอีกครั้ง ก็สามารถดึงคำตอบจาก Cache มาใช้ได้ทันที ประหยัดทั้งเวลาและค่าใช้จ่าย

- Self-hosting หรือ User-hosted LLMs (Web LLM): ในบางกรณี การโฮสต์ LLM ด้วยตัวเอง หรือให้โมเดลทำงานบน Browser ของผู้ใช้ (User-hosted LLMs/ Web LLM) ก็เป็นทางเลือกที่ช่วยลดค่าใช้จ่ายจากการเรียกใช้ API และเพิ่มความเป็นส่วนตัว การทำ Self-hosting นั้น แม้จะช่วยประหยัดค่า API แต่ก็มีค่าใช้จ่ายอื่นๆ ที่ต้องพิจารณา เช่น ค่า Hardware ค่าบำรุงรักษา และค่าไฟฟ้า Web LLM สามารถดาวน์โหลดโมเดลขนาดหลายกิกะไบต์ลงใน Browser ของผู้ใช้ และรันงานทั้งหมดโดยไม่ต้องส่งข้อมูลไปยังเซิร์ฟเวอร์

- การจัดการหน่วยความจำของ Agent: สำหรับแอปพลิเคชัน Agent การจัดการหน่วยความจำเป็นสิ่งสำคัญ เพราะทุกการโต้ตอบจะใช้ประวัติการสนทนาทั้งหมดเป็น Input ควรใช้กลยุทธ์ เช่น Conversation Summary Memory ที่สรุปประวัติการสนทนา หรือ Summary Buffer Memory ที่เก็บรายละเอียดส่วนล่าสุดและสรุปส่วนเก่า

4. การติดตามและควบคุม

การเข้าใจว่าค่าใช้จ่าย LLM ของเรามาจากไหนเป็นสิ่งสำคัญ

- ติดตามค่าใช้จ่ายต่อผู้ใช้และต่อการกระทำ: Dashboard ของ OpenAI ให้ภาพรวมค่าใช้จ่าย แต่ไม่สามารถดูละเอียดได้ว่าผู้ใช้รายใดหรือการกระทำใดที่ทำให้เกิดค่าใช้จ่าย

- ใช้เครื่องมือติดตาม: เราสามารถสร้างเครื่องมือเอง ด้วยแพลตฟอร์มอย่าง Tinybird หรือใช้แพลตฟอร์มเฉพาะทางอย่าง Langfuse และ Helicone เครื่องมือเหล่านี้ช่วยให้เราติดตามข้อมูลสำคัญ เช่น User ID, Timestamp, จำนวน Token (input, output) ค่าใช้จ่าย โมเดลที่ใช้ และประเภทของการกระทำ (Label) เพื่อช่วยให้เราระบุจุดที่ใช้จ่ายมากเกินไป

- ตั้งค่าจำกัดการใช้งาน: เราควรตั้งค่าจำกัดการใช้งาน API (Usage Limit) ในบัญชี เพื่อป้องกันค่าใช้จ่ายที่บานปลาย

การลดต้นทุน LLM ไม่ใช่แค่เรื่องเทคนิค แต่ยังรวมถึงความเข้าใจในกระบวนการทางธุรกิจและการออกแบบระบบที่ดี ด้วยกลยุทธ์ต่างๆ เช่น การเลือกโมเดลที่เหมาะสม การลดปริมาณข้อมูล การใช้ทางเลือกอื่น และการติดตามค่าใช้จ่ายอย่างใกล้ชิด เราจะสามารถสร้างแอปพลิเคชัน AI ที่มีประสิทธิภาพสูง ในขณะที่ยังคงบริหารจัดการต้นทุนได้อย่างยั่งยืน

ติดตาม SCB TechX เพื่ออัพเดทความเคลื่อนไหวเกี่ยวกับ Technology และไม่พลาดทุกโอกาสในการสร้าง Competitive Advantage ในยุคดิจิทัล ได้ที่

Facebook: https://www.facebook.com/scbtechx

LinkedIn: https://www.linkedin.com/company/scb-tech-x/?viewAsMember=true

ข้อมูลอ้างอิงราคา:

OpenAI Pricing: https://platform.openai.com/docs/pricing